Hoofdstuk 19 Datascreening

- data screening

- uitbijters.

- Onderzoekspracticum experimenteel onderzoek (PB0412)

- Onderzoekspracticum bachelor thesis (PB9916)

19.1 Inleiding

De kwaliteit van een kwantitatieve analyse valt of staat bij de kwaliteit van de gebruikte data. Er kunnen fouten in de data zijn geslopen, en soms zijn de data geen goede match met de analyseprocedures die een onderzoeker wil uitvoeren. Het is daarom van groot belang dat een kwantitatieve analyse voorafgegaan wordt door een proces van datascreening. Dat is het opschonen van de data, of wat neutraler: het verifiëren van de dataintegriteit. Simpel samengevat gaat het om de vraag: werkte alles in de studie zoals het hoorde te werken?

In dit hoofdstuk behandelen we drie globale aspecten van de datascreening die in de meeste onderzoeken in de sociale wetenschappen uitgevoerd dienen te worden. Het betreft hier:

- controleren op onmogelijke waarden

- controleren op uitbijters (extreme waarden)

- controleren van verdelingsvormen.

In dit hoofdstuk worden deze drie aspecten toegelicht. Daarnaast is er nog het probleem van ontbrekende data (missings), maar dat wordt in het hoofdstuk Ontbrekende waarden behandeld. In de toelichting is er aandacht voor de middelen die ingezet kunnen worden om de data te controleren, welke afwegingen er gemaakt moeten worden, en welke middelen voorhanden zijn om eventueel de data te ‘repareren’. Een belangrijke rode draad in dit hoofdstuk is dat er geen kant-en-klaaroplossingen bestaan. Zodra data reparatie behoeven is de onderzoeker eigenlijk altijd bezig met damage control en is er geen beste oplossing; er zijn slechts enkele suboptimale oplossingen voorhanden. Het is belangrijk om goed te begrijpen waarom we bepaalde verwachtingen van data hebben, en hoe statistische methoden die ingezet kunnen worden om de data te controleren zich tot elkaar verhouden. Wetenschappers die hun data willen bewerken, dienen bekend te zijn met hun gereedschap om zo een juiste afweging te kunnen maken.

Datascreening is verwant aan het bekijken en rapporteren van de descriptieve statistieken van de data. Dezelfde methoden worden deels gebruikt voor beide activiteiten. Bij datascreening gaat het om het opsporen van problemen in de data, terwijl het bij het rapporteren van descriptieve statistieken gaat om het beschrijven van kenmerken van de data.

19.2 Onmogelijke waarden

Nog voordat statistische methoden ingezet worden dient een onderzoeker met eenvoudige middelen de data na te lopen op onmogelijke waarden.

Onmogelijke waarden zijn waarden die niet binnen een schaalrange liggen, of die niet-bestaande categorieën aanduiden. Een onderzoeker die twee groepen onderzoekt (bijvoorbeeld een controlegroep en een experimentele groep) heeft te maken met een onmogelijke waarde als een derde conditie uit de data naar vorenkomt. Dit betreft meestal invoerfouten, zoals een ‘9’ die dikwijls als missende waarde wordt gehanteerd.

In de antwoorden op vragenlijsten kunnen, vooral bij handmatige invoer, onmogelijke waarden gevonden worden. Wanneer je een vragenlijst gebruikt waarbij de antwoordopties van een tot en met vijf lopen horen er geen andere waarden dan 1 t/m 5 in de data te staan. Waarden buiten de schaalrange zijn indicaties van invoerfouten, of van codeerfouten. Bij handmatige invoer is een veelvoorkomende invoerfout de ‘dubbele invoer’, dus als bij invoer vergeten is een cel te verspringen. Deze fout levert waarden op zoals \(44\), of \(23\), terwijl de schaal in kwestie een range van \(1\) tot \(5\) heeft. Een codeerfout wil nog wel eens ontstaan als bij invoer missende antwoorden met een onmogelijke waarde worden gecodeerd, zoals \(9\), of \(99\). De analysesoftware moet op een of andere manier de instructie krijgen om deze met opzet geïntroduceerde, onmogelijke waarden als missende waarden te beschouwen.

Er bestaan ook waarden die in alleen in een specifieke context onmogelijk zijn. Bijvoorbeeld in experimenten waar reactietijden in milliseconden (ms) worden geobserveerd kan er rekening mee gehouden worden dat \(300\) ms vaak als een minimale menselijke reactietijd beschouwd wordt. Proefpersonen die sneller dan \(300\) ms reageren op een stimulus worden daarom in reactietijdenexperimenten ook als een onmogelijke respons behandeld, dus dat de proefpersoon per ongeluk reageerde, of de opdracht op dat moment niet voldoende serieus nam. Deze onmogelijk snelle reactietijden worden om deze reden vaak zonder meer uit de data verwijderd.

Onmogelijke waarden kunnen ook uit combinaties van responsen bestaan. Het kan zijn dat iemand aangeeft al \(12\) jaar bij een bedrijf te werken, maar bij de vraag over diens leeftijd pas \(20\) jaar oud zegt te zijn. Deze soort onmogelijke waarden zijn lastiger te herkennen en vergen veel kennis van wat er in deze populatie werkelijk onmogelijk is in tegenstelling tot wat slechts onwaarschijnlijk is.

Het detecteren van onmogelijke waarden is in kleine datasets nog mogelijk door de data zelf te bekijken, maar gaat in de regel het makkelijkst wanneer frequentietabellen worden opgevraagd. Hierdoor wordt niet alleen duidelijk of er onmogelijke waarden zijn, maar wordt ook direct duidelijk hoeveel. De eerste en beste oplossing bij het detecteren van onmogelijke waarden is teruggaan naar de ruwe data, dus de data die de minste bewerking heeft ondergaan. Een waarde van \(44\) kan bijvoorbeeld een fout reflecteren waar een onderzoeker per ongeluk tweemaal een vier typte. Maar het kan ook een fout zijn waarbij verzuimd is om een kolom op te schuiven, waardoor het antwoord op de volgende vraag per ongeluk in dezelfde cel geplaatst is als die van de vorige vraag. Enkel de fysieke vragenlijst van de respondent in kwestie kan dan een definitief antwoord opleveren.

Onmogelijke waarden die niet het gevolg zijn van invoerfouten zijn lastiger te detecteren. Ook hier is de eerste en beste oplossing: ga terug naar de ruwste data. Als de data verkregen worden door een computerprogramma dat automatisch videobeelden codeert, bijvoorbeeld de beweging van deelnemers door een ruimte, dan kunnen enkel de videobeelden een antwoord geven op de vraag of de onmogelijke waarde een invoerfout is, het gevolg van technisch falen, of een waarde die toch niet onmogelijk blijkt.

Als uit inspectie van de ruwst mogelijke data blijkt dat de onmogelijke observaties van oorsprong wel mogelijke observaties waren, dan kunnen de betreffende waarden worden vervangen. Als een waarde onmogelijk is (let op: niet slechts onwaarschijnlijk), en er is geen objectieve manier om vast te stellen wat de werkelijke waarde zou moeten zijn, dan zal de onmogelijke waarde verwijderd moeten worden. Het is verleidelijk om een waarde van \(44\) op een vijfpuntsschaal te veranderen in een \(4\), maar zonder objectief bewijs dat er een \(4\) had moeten staan in plaats van \(44\) is het risico aanwezig dat een duidelijke fout verandert in een onzichtbare fout. Hoe zeker we ook denken te zijn: er is altijd een kans dat er iets anders dan \(4\) had moeten staan. Als niet bekend is wat de juiste waarde was, dan kunnen onmogelijke waarden het beste vervangen worden door een missende waarde. Als de data in het onderzoek niet anoniem verzameld zijn, dan kan het nog mogelijk zijn (afhankelijk van de onderzoekscontext en verkregen toestemming) om deelnemers te vragen naar de onmogelijke waarde. Wellicht is er een logische verklaring voor wat onmogelijke data leken, of kan de deelnemer aangeven of het datapunt een fout betreft, en misschien zelfs wat de juiste waarde had moeten zijn.

Wanneer data aangepast moeten worden is het altijd belangrijk om dit repliceerbaar en transparant te doen. Het is daarom uiterst belangrijk om de aanpassing middels een analysescript (code) te doen, of het op zo’n manier te doen dat er een codescript van wordt gegenereerd, zoals SPSS-syntax, of een aantal regels code in R. Er zijn een aantal zeer grote risico’s die een onderzoeker neemt bij het ‘codeloos’ verwijderen van data:

- verlies van repliceerbaarheid: als de data opnieuw opgeschoond moeten worden dan moet de onderzoeker onmogelijke waarden opnieuw gaan zoeken en aanpassen.

- verlies van transparantie: een andere onderzoeker die analyses op de data wilt doen zal bij handmatig verwijderen niet kunnen weten welke data als onmogelijk gezien werd, en dat deze verwijderd zijn, of nog moeten worden.

Voorkomen is beter dan genezen. Een voorbereide onderzoeker anticipeert op onmogelijke data. Tijdens experimenten is het van groot belang om een zogeheten labjournaal bij te houden. Dit is een logboek waarin alle bijzonderheden die zich tijdens een experiment voordoen, worden bijgehouden. Zoals een computer die het begeeft, een hartslagmeter die losraakt, of een respondent die tijdens het experiment deelname staakt. Met het labjournaal bij de hand kunnen opmerkelijke data vaak verklaard worden, wat een beslissing over wat er met de data moet gebeuren vergemakkelijkt. In survey-onderzoek kan een document met bijzonderheden worden bijgehouden. Deelnemers kunnen bijvoorbeeld telefonisch of schriftelijk doorgeven dat er iets mis is gegaan bij het invullen, of dat er per ongeluk een verkeerd antwoord gegeven is. Denk hierbij bijvoorbeeld aan respondenten die hun leeftijd in jaren hebben ingevuld wanneer de onderzoeker vroeg naar leeftijd in maanden. Wanneer dit in een document is genoteerd kan deze informatie gebruikt worden om eventuele onmogelijke waarden te repareren.

19.3 Uitbijters

Individuele observaties die erg veel afwijken van de overige observaties in de dataset worden dikwijls uitbijters (Engels: outliers) genoemd. Hoe het mogelijk is dat sommige observaties extreem afwijken van de overige data is vaak moeilijk te bepalen, maar uitbijters kunnen de conclusies van een onderzoek beïnvloeden doordat ze in staat zijn om de statistische analyses ernstig te verstoren.

Anders dan onmogelijke waarden kunnen uitbijters zeldzame waarden betreffen die mogelijk zijn in de populatie, of die mogelijk zijn in een andere populatie dan waar de onderzoeker in geïnteresseerd is. Wanneer een onderzoeker een nieuwe behandeling tegen depressie wil onderzoeken en bij een voormeting opmerkt dat een proefpersoon een extreem lage depressiescore heeft, dan kan het zijn dat de proefpersoon in kwestie een realistische depressiescore heeft voor iemand die niet depressief is. De score is dus mogelijk, alleen behoort de betreffende proefpersoon niet tot de populatie ‘mensen met depressie’ waar de onderzoeker een steekproef uit wilde trekken.

Er zijn in het algemeen twee soorten uitbijters te onderscheiden:

- univariate uitbijters

- multivariate uitbijters.

Univariate uitbijters zijn extreme waarnemingen op één variabele en in vergelijking met andere waarnemingen in diezelfde variabele. Een voorbeeld van een univariate uitbijter is een zeer hoge IQ-score (bijvoorbeeld \(180\)), terwijl de overige IQ-scores gemiddeld \(120\) zijn en tussen de \(110\) en \(130\) liggen. Een ander voorbeeld is een zeer lage leeftijd bij een aantal deelnemers (bijvoorbeeld \(18\) jaar, \(22\) jaar), terwijl de overige deelnemers een leeftijd van rond de \(40\) hebben. Het gaat hier dus om extremen binnen één variabele.

Multivariate uitbijters zijn extreme combinaties van waarnemingen. Het is mogelijk om in een onderzoek naar jong volwassenen een deelnemer te hebben die \(18\) jaar oud is, of om een deelnemer te hebben die een bruto inkomen van \(70.000\) per jaar heeft. Maar een deelnemer die \(18\) jaar oud is én een bruto inkomen van \(70.000\) heeft is in een ‘normale’ populatie opmerkelijk. Een multivariate uitbijter is dus een ongewone combinatie van scores op twee of meer variabelen. Het kan zijn dat de multivariate uitbijter voortkomt uit een combinatie van univariate uitbijters. Maar zoals in het voorbeeld van de extreem goed verdienende 18-jarige kan het ook zijn dat een multivariate uitbijter een combinatie van scores is die enkel opmerkelijk worden als deze zich tegelijk voordoen.

Uitbijters kunnen ook het gevolg zijn van scheve steekproefverdelingen. Het kan wel eens gebeuren dat proefpersonen in een experiment per ongeluk een veel te makkelijke taak aangeboden krijgen, bijvoorbeeld zo makkelijk dat vrijwel niemand daar fouten in maakt. Dit leidt tot de ongemakkelijke situatie dat de enkele proefpersoon die een paar fouten maakt een uitbijter is, enkel en alleen doordat de overgrote meerderheid geen enkele fout maakt.

Het dilemma waarvoor uitbijters de onderzoeker stellen is dat hun aanwezigheid een lose-lose-situatie oplevert. De uitbijters in de data ongemoeid laten leidt tot vertekende en misschien zelfs onjuiste conclusies. De uitbijters verwijderen, of aanpassen vertekent mogelijk de data op subtielere manieren, bijvoorbeeld doordat de steekproef nu een minder complete of onjuiste afspiegeling van de populatie is, of de variantie kunstmatig kleiner wordt gemaakt, waardoor het (mogelijk onterecht) makkelijker wordt om significante verbanden te vinden.

19.3.1 Visueel voorbeeld: uitbijters geïllustreerd

Om te verduidelijken hoe uitbijters statistische analyes kunnen verstoren is het handig om te visualiseren hoe statistische verbanden door uitbijters vertekend kunnen raken. In twee figuren kun je zien hoe extreme waarden modelschattingen kunnen vertekenen.

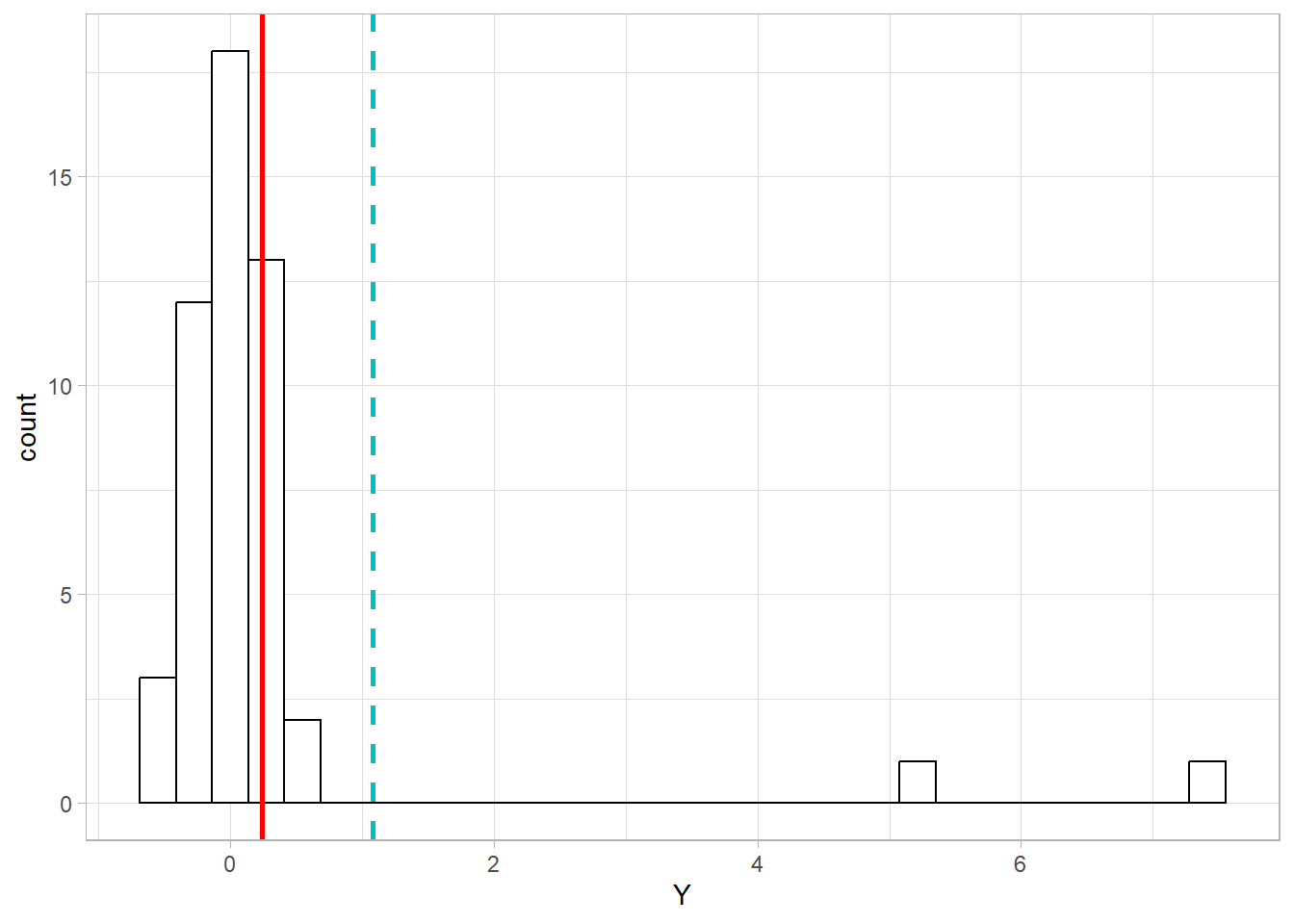

Figuur 19.1 illustreert de invloed van univariate uitbijters. De vaste lijn laat het ‘werkelijke’ (populatie-)gemiddelde zien. De stippellijn illustreert waar het gemiddelde ligt dat berekend is op basis van de data, inclusief de uitbijters. Het gemiddelde dat van de gehele dataset berekend wordt is geen goede weergave van het centrum van de verdeling. Een onderzoeker die de uitbijters in de data laat zal met een grove overschatting van het gemiddelde van de verdeling te maken hebben, en loopt het risico verkeerde conclusies te trekken.

Figuur 19.1: Voorbeeld van univariate uitbijters

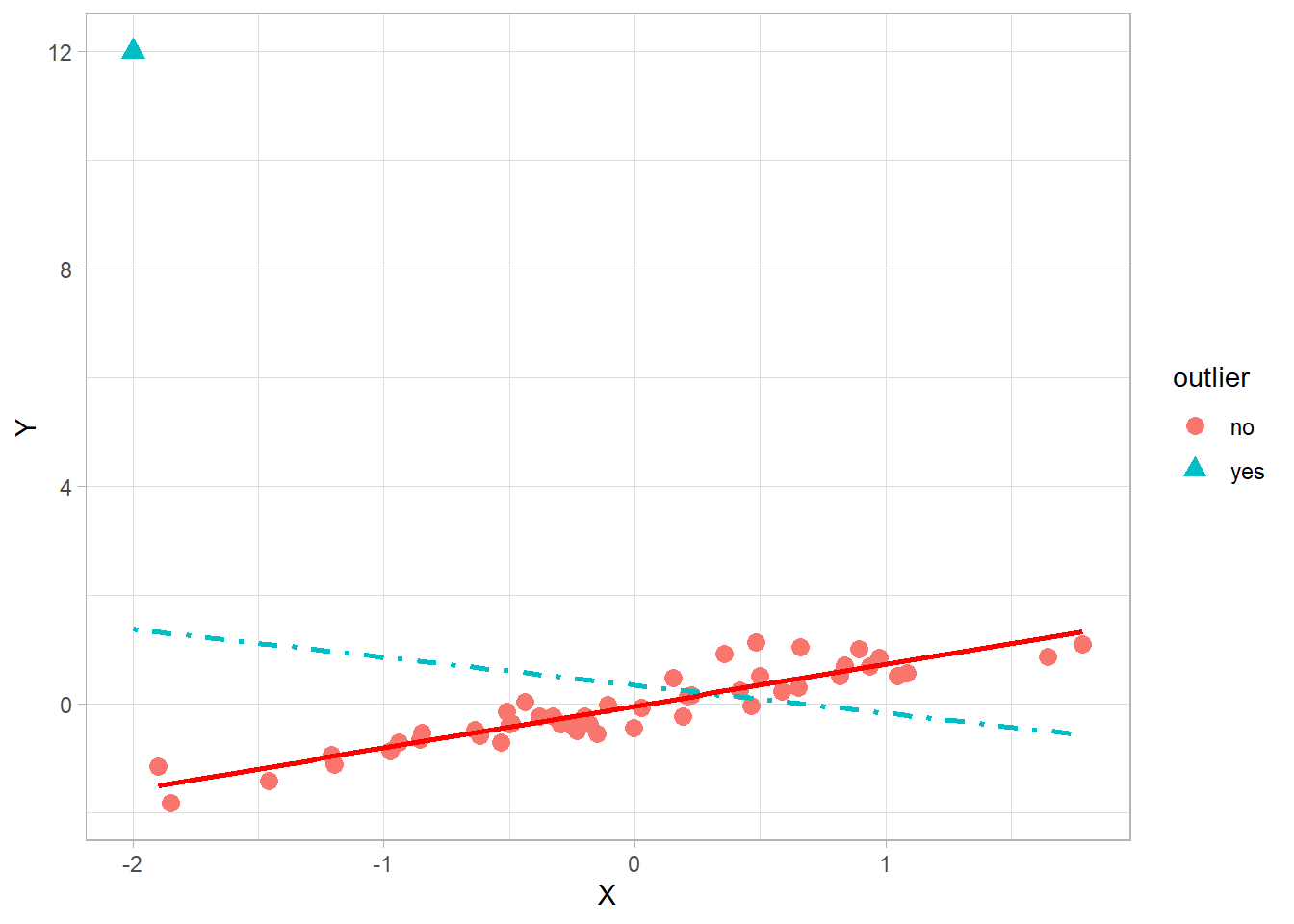

Een extreme illustratie van multivariate uitbijters is weergegeven in Figuur 19.2. De vaste lijn geeft het ‘werkelijke’ (populatie-)verband weer tussen X en Y, en is een oplopende lijn door de puntenwolk zonder uitbijters. Het verband in de populatie is positief, dus als X toeneemt dan neemt Y ook toe. De gestreepte lijn illustreert het verband waar de uitbijters in meegewogen worden. Zodra de uitbijters in de berekening van het verband worden opgenomen dan is dat in dit voorbeeld zo extreem dat het de aard van het verband verandert; de uitbijters ‘trekken het verband naar een negatief verband’. De onderzoeker zou (onjuist) concluderen dat een toename van X gepaard gaat met een daling van Y.

Figuur 19.2: Voorbeeld multivariate uitbijters

19.3.2 Wat te doen met uitbijters?

Het is belangrijk om te realiseren dat er geen algemeen geaccepteerde beste oplossing is voor uitbijters. Zoals we eerder al zeiden: uitbijters plaatsen de onderzoeker eigenlijk altijd voor een lose-lose-situatie. Op het moment dat er uitbijters zijn, dan rest eigenlijk slechts nog damage control. In deze sectie worden een aantal eenvoudige richtlijnen besproken. Geavanceerde oplossingen worden enkel kort benoemd, maar omdat deze technieken veel achtergrondkennis vereisen worden deze niet in dit introducerende hoofdstuk in detail toegelicht.

Grofweg zijn er twee criteria die men kan hanteren om te bepalen of een waarde een uitbijter is: (a) of de waarde extreem afwijkt van een centrum (bijvoorbeeld het gemiddelde van de variabele), of (b) of de waarde (extreem veel) invloed heeft op het te schatten model. Met deze twee criteria in het achterhoofd zijn er voor uitbijters vier eenvoudige oplossingen voorhanden, ieder met eigen voor- en nadelen:

- negeren van de uitbijter

- verwijderen van de uitbijter

- gebruik van een andere centrummaat, of van een non-parametrische statistische methode (verlagen van het meetniveau)

- de uitbijter aanpassen, zodat deze geen uitbijter meer is.

Ten slotte kan men ook een zogenaamde robuuste analysetechniek gebruiken, die ongevoeliger is voor uitbijters dan de standaard analysetechniek. De essentie van robuuste technieken is meestal dat extreme waarden automatisch een kleiner gewicht krijgen, zodat hun invloed op de resultaten kleiner wordt. Hier zullen we in dit hoofdstuk verder niet op ingaan.

Negeren. De uitbijter kan genegeerd worden. In sectie 19.3.3 wordt beknopt besproken welke statistische methoden kunnen helpen om tot dit besluit te komen. Een situatie waar dit besluit vaak passend is, is wanneer de uitbijter de uitkomsten van een analyse niet echt verstoort. Als er geen goede reden is om aan te nemen dat de uitbijter een observatie is uit een andere populatie, en dus niet in de steekproef thuishoort, dan kan het sterk aan te raden zijn om de data zoveel mogelijk intact te laten. De uitbijter is misschien een extreme observatie, maar misschien ook wel een observatie die de ‘werkelijkheid’ beschrijft. Als de uitbijter niet zoveel invloed heeft dat die de conclusies kan veranderen, dan is het soms beter om van de uitbijter af te blijven.

Verwijderen. Je kunt ook besluiten om een uitbijter te verwijderen. Dit wordt dikwijls trimming genoemd. Als de conclusies niet wezenlijk veranderen door een uitbijter, dan kan het verwijderen van een uitbijter wel voor een model zorgen met minder ‘ruis’, dus minder meetfout. Het blind verwijderen van uitbijters is echter niet de bedoeling. Verwijderen is een sterke optie als er reden is om aan te nemen dat de uitbijter eigenlijk niet tot de steekproef behoort.

Of je nu kiest voor verwijderen of ongemoeid laten van uitbijters, het is altijd belangrijk om hierover transparant te zijn in je rapportage. Voer bijvoorbeeld de analyse tweemaal uit: een keer met, en een keer zonder uitbijters. Als de uitkomsten niet wezenlijk anders zijn, dan staat het de onderzoeker vrij om de uitbijters te behouden of verwijderen. Zolang in het verslag beschreven wordt dat er twee analyses zijn gedaan, of er verschillen waren of niet, en welke data gekozen zijn voor verdere analyse, dan is dat vaak een acceptabele oplossing.

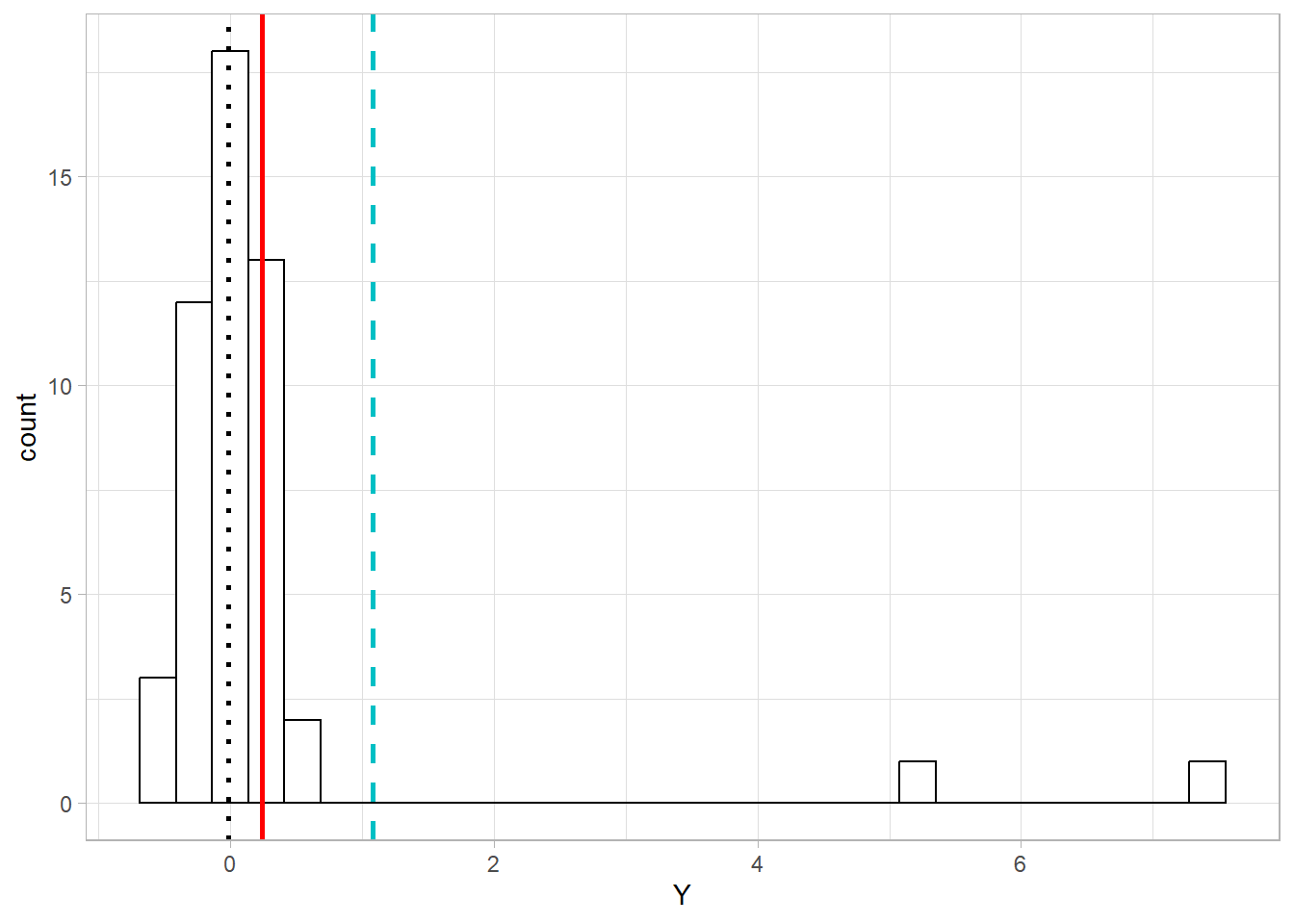

Verlagen meetniveau. Een andere mogelijkheid is om niet aan de data zelf te komen, maar deze alleen anders te behandelen. Een gemiddelde is erg gevoelig voor uitbijters, maar een mediaan is tegen uitbijters goed bestand. Figuur 19.3 illustreert hoe een mediaan bij aanwezigheid van uitbijters een betere schatting geeft van het populatiegemiddelde dan het steekproefgemiddelde. Het populatiegemiddelde is hier nul. De mediaan van de steekproef is ook nul, terwijl de steekproefgemiddelden met en zonder uitbijters beide hoger liggen dan het populatiegemiddelde.

Figuur 19.3: Voorbeeld van de mediaan (stippellijn) in vergelijking tot het steekproefgemiddelde (gestreepte lijn), om het populatiegemiddelde te schatten in aanwezigheid van uitbijters.

Het berekenen van de mediaan in plaats van het gemiddelde komt neer op het verlagen van het meetniveau van de data. De data worden niet meer als interval/ratio behandeld, maar als ordinaal. Er zijn statistische analyses die uitgaan van een ordinaal meetniveau van de data, de zogeheten nonparametrische toetsen. Deze toetsen hebben met elkaar gemeen dat ze zich enkel richten op de ordening van de scores zonder de intervallen tussen scores mee te wegen. Daardoor hebben ze minder power dan de zogeheten parametrische toetsen. Maar als de data erg scheef zijn, kan dit structurele verlies van power ruimschoots gecompenseerd worden door een robuustere schatting van het centrum van de verdeling en de meetfout.

Een groot nadeel is echter dat er niet voor alle parametrische methoden een vergelijkbare non-parametrische methode voorhanden is. Voor de beschrijving van data is het eenvoudig om de mediaan in plaats van het gemiddelde te gebruiken. Ook voor eenvoudige toetsen van verbanden, zoals correlaties, t-toets, of de one-way ANOVA zijn er goede non-parametrische alternatieven voorhanden. Maar er zijn weinig opties voor het non-parametrisch benaderen van complexere analyses. Het is dus niet altijd mogelijk om uitbijters ongemoeid te laten door de data te behandelen alsof die op een lager meetniveau is gemeten.

Aanpassen. De laatste, eenvoudige, oplossing is de uitbijter aanpassen, zodat deze geen uitbijter meer is. Dit wordt winsorizing genoemd. De waarde van de uitbijter wordt vervangen door een minder extreme waarde. Soms wordt ervoor gekozen om de hoogste niet-extreme waarde van de variabele te gebruiken als vervangende waarde. Maar vaker kiest men voor een waarde van één meeteenheid (unit) hoger dan de hoogste niet-extreme waarde, zodat de voormalige uitbijter nog wel de hoogste waarde is, maar niet meer zo extreem. Stel bijvoorbeeld dat er bijgehouden is hoeveel bier per week een student drinkt. Als de verschillen tussen studenten ongeveer één biertje zijn (\(2\), \(3\), \(5\) of \(6\) per week), dan zou een relatief extreme waarneming zoals \(14\) per week aangepast kunnen worden naar de volgende hoogste plus één bier, dus bijvoorbeeld naar \(7\) per week. Het is nu nog steeds de hoogste waarneming, maar minder extreem.

Winsorizing kan heel subjectief worden, bijvoorbeeld omdat er geen echte definitie is voor een ‘unit’. Dit komt meestal aan op gevoel, bijvoorbeeld door te bepalen hoeveel afstand de observaties in de regel tot elkaar hebben. Als vervangingswaarde voor uitbijters tel je deze afstand dan op bij de waarde van de hoogste niet-extreme waarde.

Winsorizing is een methode die tussen verwijderen van uitbijters en verlagen van het meetniveau instaat. Bij het verwijderen van uitbijters stelt een onderzoeker expliciet:‘Ik onderzoek de subpopulatie waarin deze uitbijters, de staarten van de populatieverdeling, niet bestaan.’ Deze stellingname is gepast wanneer de uitbijters ‘echte’ uitbijters zijn en dus eigenlijk niet in de steekproef thuishoren, omdat ze niet tot de populatie behoren waarin de onderzoeker geïnteresseerd is. Maar als de onderzoeker wel geïnteresseerd is in deze uitbijters, maar hun extreme invloed op bijvoorbeeld de verdelingsvorm wil minimaliseren, dan is winsorizing een mogelijkheid om met uitbijters om te gaan.

Houd er rekening mee dat winsorizing een mooie term is, en eigenlijk een eufemism, voor wat in feite datamanipulatie betreft. Het is dus van uiterst groot belang dat de onderzoeker transparant is over het winsorizen van data. De lezer moet weten dat er data zijn aangepast, om hoeveel observaties het daarbij gaat, en welke vervangende waarden gebruikt zijn. Net als bij het verwijderen of negeren van uitbijters kan het handig zijn om een analyse met en zonder winsorizing uit te voeren, en de lezer te informeren over de impact van winsorising op de conclusies.

19.3.3 Identificeren van uitbijters

Het is mogelijk om statistische methoden te gebruiken om extreme observaties te identificeren. Maar het kan niet voldoende benadrukt worden dat er een wezenlijk verschil is tussen een extreme observatie een een uitbijter. Uitbijters zijn altijd extreme observaties, maar extreme observaties zijn niet altijd uitbijters. Een uitbijter is namelijk een extreme waarde die bovendien niet tot de populatie behoort waaruit de onderzoeker een steekproef wilde trekken. Als je met behulp van statistische methoden extreme observaties hebt geïdentificeerd, moet er dus vervolgens nog steeds een evaluatie plaatsvinden om te bepalen of de extreme observatie een échte uitbijter is.

Statistische methoden behoeven zoals altijd een voetnoot. Het statistisch bepalen of een observatie extreem is wordt altijd op arbitraire criteria besloten. Wat een acceptabele drempelwaarde voor ‘extreem’ is hangt heel sterk af van het onderzoeksveld en de onderzoekscontext. Een onderzoeker die geluidsgolven analyseert kan het zich dikwijls veroorloven om grofweg de laagste en hoogste \(5\) procent van alle waarnemingen te verwijderen om zo een duidelijk signaal op te vangen. In psychologisch onderzoek kan het aan te raden zijn om niet te streng te zijn. Een universele richtlijn is er niet, dus er zullen vele adviezen en grenswaarden te vinden zijn. In deze sectie geven we een overzicht van enkele methoden om extreme waarden op te sporen en van gangbare drempelwaarden/criteria in de sociale en gedragswetenschappen.

19.3.3.1 Univariate uitbijters

De steekproefverdeling is nagenoeg normaal verdeeld. Wanneer de verdeling van de steekproef als normaal verdeeld kan worden verondersteld, dan is het gemiddelde een goede schatter van het centrum van de verdeling. Dat is dan dus ook een goede schatter om te bepalen of een observatie ver van dit centrum verwijderd is.

De variabele die op extreme waarden gecontroleerd wordt kan gestandaardiseerd worden, dus de observaties kunnen omgezet worden naar z-scores. Dit betekent dat het gemiddelde van de variabele van iedere observatie wordt afgetrokken, en dat dit verschil vervolgens gedeeld wordt door de standaarddeviatie van de variabele.

\[\begin{equation} z_i = \frac{X_i - \bar{X}}{s_X} \tag{19.1} \end{equation}\]

Het gemiddelde en de standaarddeviatie van de gestandaardiseerde variabele is \(M = 0\) en \(SD = 1\).

Door observaties om te zetten naar z-scores worden de waarden omgezet naar ‘hoeveel standaardeviaties zij van het gemiddelde liggen’. Een z-score van 1.00 betekent dat de observatie één standaarddeviatie boven het gemiddelde ligt. Het voordeel van z-scores is dat ze niet-steekproefgrootte afhankelijk zijn, en dat een z-score direct omgezet kan worden naar een p-waarde. Die geeft aan hoe zeldzaam een geobserveerde waarde is in de populatie als die perfect normaal verdeeld zou zijn. Een z-score van \(1.00\) heeft een p-waarde van 0.317.

Een zeer streng z-score-criterium zou zijn om alle observaties met een z-score van (plus of min) \(1.96\) (\(p < .05\)) als extreme observaties te classificeren. Dat is dus een alfa van \(\alpha = .05\).

Een alfa van \(\alpha = .05\) brengt een groot risico op valse positieven met zich mee. Dan worden er dus mogelijk teveel observaties als extreem geïdentificeerd, terwijl deze eigenlijk in de populatie niet echt extreem zijn. Een kleinere alfa, \(\alpha = .001\) heeft dan ook bij velen de voorkeur. Dit betekent dat men vaak voor z-scores extremer dan (plus of min) \(3.29\) kiest als drempelwaarde. Deze lage alfa helpt om te zorgen dat enkel de extreemste observaties geïdentificeerd worden als uitbijter, en dat een onderzoeker niet in de verleiding komt data in de ‘gewone’ staarten van de verdeling te manipuleren.

Tenslotte is het goed om te beseffen dat het gemiddelde en de standaarddeviatie die voor de berekening van z-scores nodig zijn, zelf ook worden beïnvloed door uitbijters. Het gebruik van z-scores is daardoor een niet erg robuuste methode om uitbijters te identificeren.

De steekproefverdeling is scheef verdeeld. Wanneer de verdeling van de steekproef niet als normaal verdeeld kan worden verondersteld, dan is het gemiddelde geen goede schatter van het centrum van de verdeling. Het kan dan beter zijn om de mediaan te gebruiken als centrummaat. De spreidingsmaat op basis van de mediaan, de interkwartielafstand (Engels: interquartile range, IQR), kan dan worden gebruikt om extreme observaties te identificeren. De mediaan wordt vijwel niet door uitbijters beïnvloed en is daarmee een robuuste maat.

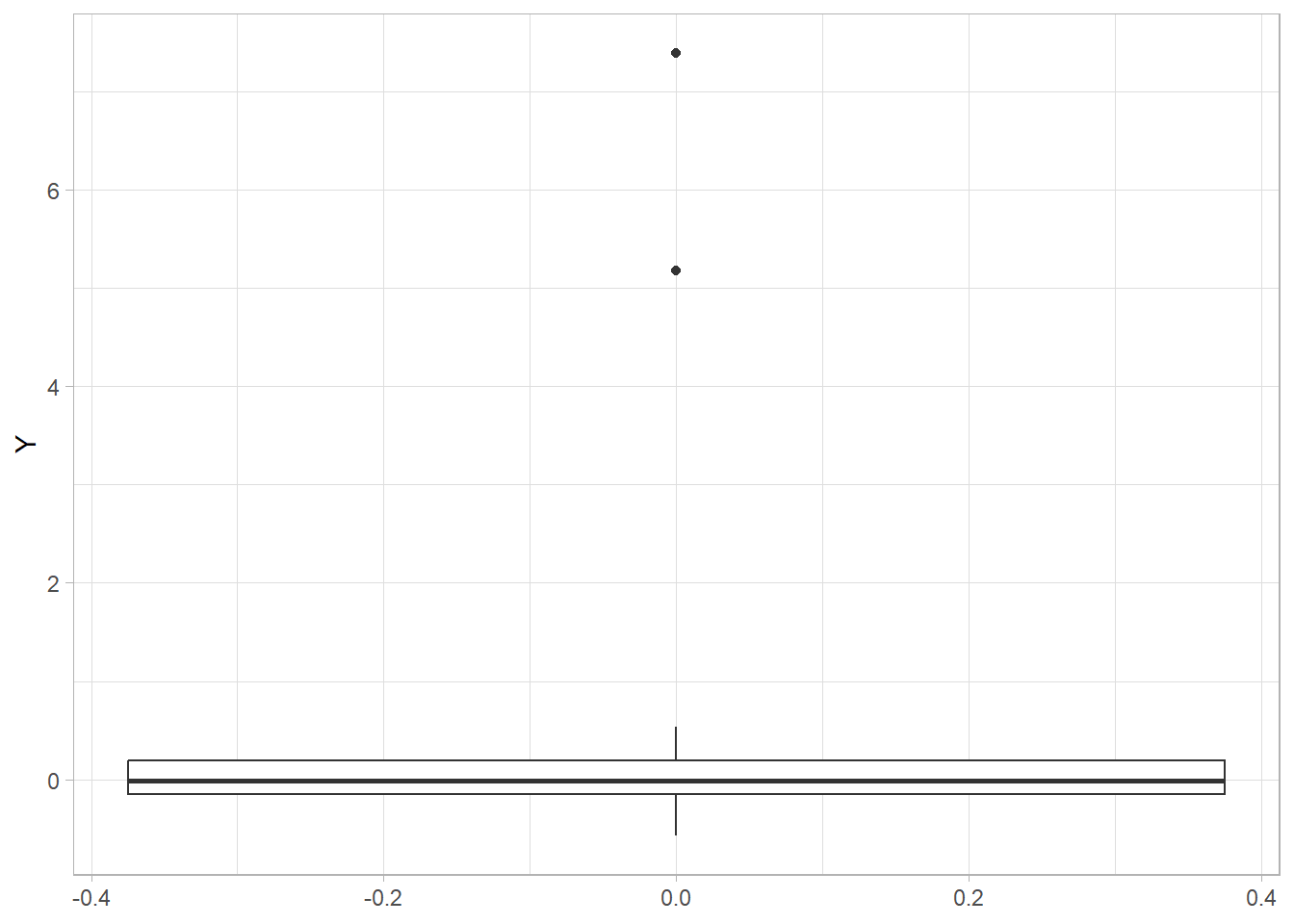

De makkelijkste methode om op basis van de mediaan uitbijters te identificeren is door boxplots op te vragen. De meeste softwarepakketten zullen boxplots (standaard) weergeven op een wijze die extreme observaties onderscheidt van de overige observaties. Figuur 19.4 hieronder is een voorbeeld van een boxplot die extreme waarden onderscheidt.

Figuur 19.4: Boxplot waar twee extreme waarden worden getoond

Net als bij z-scores is het ook bij gebruik van de interkwartielafstand aan de onderzoeker om een drempelwaarde voor uitbijters te kiezen. Welke drempelwaarde gehanteerd wordt is arbitrair. Twee criteria zijn populair: observaties worden als extreem geclassificeerd wanneer zij \(1.5\) keer de interkwartielafstand van het eerste of derde kwartiel verwijderd zijn, of wanneer zij \(3.0\) keer de interkwartielafstand van het eerste of derde kwartiel verwijderd zijn. Concreet betekent dit dat bijvoorbeeld een punt als uitbijter wordt geclassificeerd als zijn waarde groter is dan de waarde corresponderend met het derde kwartiel plus \(1.5\) keer de IQR.

Een criterium van \(1.5\) keer de IQR kan erg streng zijn. Sommige software maakt om deze reden visueel een onderscheid tussen scores die \(1.5\) of \(3.0\) keer van de IQR afwijken, bijvoorbeeld door \(1.5\) x IQR als bolletjes en \(3.0\) x IQR als sterretjes weer te geven in de boxplot. Net als bij z-scores kan het zinvol zijn om te kiezen voor een drempelwaarde die het aantal valse positieven minimaliseert.

Omdat elke drempelwaarde arbitrair is, is het wederom van groot belang dat je transparant bent over je keuzes.

19.3.3.2 Multivariate uitbijters

Mahalanobis-afstand. Een populaire methode om multivariate extreme observaties te identificeren is door het berekenen van de mahalanobis-afstand. Om het eenvoudig uit te leggen: een meerdimensionale scatterplot wordt zo gedraaid en vervormt dat de punten die de scatterplot vormen een cirkel- of meerdimensionale bolvorm vormen. Het coördinatenstelsel wordt zo aangepast dat de X- en Y-as dezelfde schaal hebben. Het is eigenlijk een vorm van multidimensionaal standaardiseren.

De mahalanobis-afstand is vergelijkbaar met de z-score: het is de afstand van een punt tot het centrum van de ‘gestandaardiseerde’ puntenwolk. Het standaardiseren van univariate data (delen door de \(SD\)) gaf de variabele een z-verdeling, en daarmee kon de p-waarde van een gegeven z-score (en extremer) worden berekend. Het standaardiseren tot mahalanobis-afstanden leidt ertoe dat de mahalanobis-afstanden \(\chi^2\)-verdeeld zijn. Om de p-waarde te bepalen bij een \(\chi^2\)-verdeling moeten vrijheidsgraden worden meegewogen. De vrijheidsgraden zijn gelijk aan het aantal variabelen waar de mahalobis-afstanden voor berekend worden. Dus een zoektocht naar multivariate uitbijters in een set van acht variabelen heeft een aantal vrijheidsgraden van \(df = 8\). Bij het gegeven aantal vrijheidsgraden kan de drempelwaarde van \(\chi^2\) bepaald worden waarboven combinaties van observaties als multivariate uitbijters worden geclassificeerd, op basis van een door de onderzoeker gekozen alfa, bijvoorbeeld \(\alpha < .001\). Bij twee variabelen (\(df = 2\)) geldt bijvoorbeeld \(Md > 13.82\) als criterium voor een uitbijter, omdat voor de bijbehorende chi-kwadraat daar geldt: \(p < .001\).

19.3.4 Bijzondere datapatronen

Voor onmogelijke waarden en uitbijters bestaan veel identificatiemethoden en er zijn voldoende richtlijnen voor het omgaan met deze waarnemingen voorhanden. Maar er zijn ook (combinaties van) waarnemingen die je als onderzoeker niet in je dataset wil hebben, maar die moeilijker op te sporen zijn. Het kan bijvoorbeeld zijn dat respondenten het onderzoek niet voldoende serieus namen, niet goed hun aandacht bij de taak, vragenlijst, of interventie hadden, of zelfs opzettelijk ‘onzinnige’ data leverden.

Een datapatroon dat zich soms voordoet bij het afnemen van vragenlijsten is wat straightlining genoemd wordt. Deelnemers geven dan op iedere vraag in een (deel van een) vragenlijst hetzelfde antwoord, of ze volgen een rechtlijnig antwoordpatroon. Ze kiezen steeds bijvoorbeeld de laagste of de hoogste antwoordoptie, of kiezen antwoordopties in een kris-kraspatroon.

Het kan bijzonder lastig zijn om zulke datapatronen te herkennen. In het kader van ‘voorkomen is beter dan genezen’ wordt in vragenlijsten nog wel eens gebruik gemaakt van het omdraaien van de schaalrichting van een vraag. Een serie vragen waarbij een hogere score ‘meer’ betekent, wordt bijvoorbeeld afgewisseld met vragen waarbij een hogere score ‘minder’ betekent. Hoewel dit zogeheten ‘ompolen’ van vragenlijstitems populair is, is deze methode niet zonder controverse.

Een negatief gestelde vraag is namelijk niet altijd hetzelfde als een omgekeerde positief gestelde vraag. Vragen op een vijfpuntschaal hoe ‘blij’ iemand is, meet niet inhoudelijk hetzelfde als vragen hoe ‘boos’ iemand is, of hoe ‘niet blij’. Bij ompolen kan het middel dus erger zijn dan de kwaal. Een paar ‘lastige’ deelnemers die items om welke reden dan ook niet naar waarheid beantwoorden, kunnen een negatieve invloed hebben op de betrouwbaarheid van de data. Maar een vragenlijst met items die een construct niet meer goed dekken bedreigt de validiteit van het hele onderzoek. De beste methode om straightlining te voorkomen is te zorgen dat respondenten gemotiveerd aan het onderzoek deelnemen.

Als zulke bijzondere datapatronen zich voordoen en als deze geïdentificeerd kunnen worden, dan is er helaas meestal geen reparatie mogelijk. De data van de deelnemers waarbij deze patronen zich voordoen kunnen vaak het beste in hun geheel uit de analyse worden verwijderd. Hier is maatwerk van groot belang. Een onderzoeker moet dus altijd proberen vast te stellen waarom respondenten een vragenlijst op bijzondere wijze hebben ingevuld, of een taak niet met de juiste aandacht hebben uitgevoerd. Wanneer het opvalt dat onwelgevallige patronen zich aan het einde van een dataverzamelingsessie voordoen, dan kan de oorzaak liggen in uitputting. De data uit het vroege deel van de dataverzamelingsessie kan dan nog bruikbaar zijn.

Een ander moment waarop deelnemers afhaken, kan zijn bij vragen naar zaken die ze als zeer privé of als erg gevoelig beschouwen. In een onderzoek onder leerkrachten naar hun doceerstijl en hun mening over leerlingen met een migratieachtergrond zullen respondenten bijvoorbeeld waarschijnlijk aandachtig antwoorden op vragen over hoe zij doceren. Maar mogelijk voelen ze zich te onveilig om te antwoorden op vragen over hoe ze over migranten denken. Hier is het dan handig als de onderzoeker de meest gevoelige data zoveel mogelijk laat in het dataverzamelingsproces verzamelt. Een afhaker heeft dan in ieder geval op de eerdere observaties nog bruikbare data kunnen opleveren. Ook is het verstandig om vooraf heel duidelijk te maken hoe de data verwerkt worden en wie ze te zien krijgt.

19.4 Sensitiviteitsanalyse

In eerdere secties gaven we meermaals het advies om wanneer er iets ‘mis’ is met de data de geplande hypothesetoetsing tweemaal uit te voeren: eenmaal met de dataset zonder aanpassing, en eenmaal met aanpassing. Hoewel de schade van uitbijters en ongewenste verdelingsvormen gering kan zijn, en ze dus de uiteindelijke conclusies niet veranderen, betekent dit niet automatisch dat het geen probleem oplevert. Elke beslissing die wordt genomen over het omgaan met foute, extreme of ontbrekende waarden heeft invloed op de uitkomsten, zoals bijvoorbeeld de schatting van een correlatiecoëfficiënt. In de inferentie naar de populatie kunnen, zelfs als de globale conclusies intact blijven, de sterkte van effecten onder- of overschat worden.

Desondanks kan het het nuttig zijn om een toch systematisch een analyse te herhalen. Deze procedure wordt een sensitiviteitsanalyse genoemd. Met sensitiviteitsanalyse wordt geen speciale statistische analyse bedoeld, maar het herhalen van de analyse onder verschillende omstandigheden. Daarmee ga je na in hoeverre de uitkomsten worden beïnvloed door bepaalde waargenomen problemen met de data. Met een sensitiviteitsanalyse wordt eigenlijk geëvalueerd hoe repliceerbaar of robuust de resultaten zijn, door systematisch steeds iets te veranderen, zoals ontbrekende waarden imputeren, of steeds de extreemste overgebleven uitbijter te verwijderen. Een sensitiviteitsanalyse kan ook in een veel bredere context worden toegepast, maar hier beperken we ons tot de datascreening.

Als blijkt dat de resultaten sterk afhangen van de gekozen strategie om om te gaan met extreme of ontbrekende waarden, dan zijn de resultaten niet robuust. Deze zijn dan namelijk blijkbaar gevoelig voor ‘data-ruis’, dus willekeurige verstorende observaties. Als daarentegen blijkt dat de resultaten nauwelijks wijzigen onder invloed van verschillende keuzes, dan zijn deze resultaten robuust. Het maakt dan niet heel veel uit welke keuze je maakt bij het omgaan met extreme of ontbrekende waarden. Ongeacht de robuustheid van je resultaten is het altijd belangrijk om een geïnformeerde keuze te maken als reactie op de datascreening en eventuele sensitiviteitsanalyse.

Zorg altijd dat in je rapportage duidelijk is hoe je de datascreening hebt uitgevoerd, met welk criterium, wat het resultaat was en wat je hebt gedaan in reactie daarop. Als er een sensitiviteitsanalyse is gedaan dan is dit zeker iets om in de rapportage op te nemen, meestal in een bijlage.

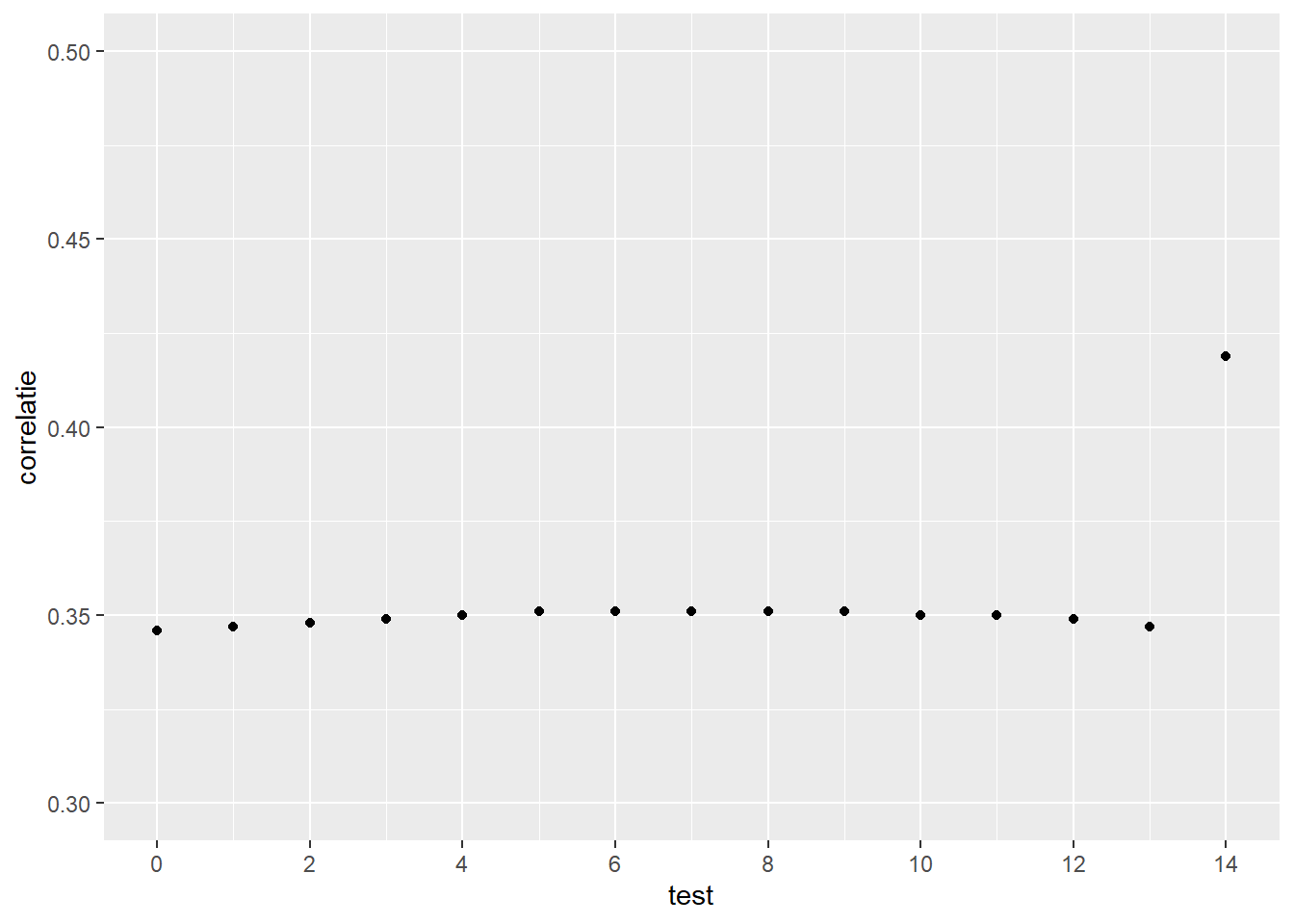

Figuur 19.5: Voorbeeld sensitiviteitsanalyse

In Figuur 19.5 wordt het resultaat van een eenvoudige sensitiviteitsanalyse getoond. Dit voorbeeld is gebaseerd op de data met de univariate uitbijters erin, waarbij de correlatie tussen de twee variabelen is uitgerekend. Het probleem dat we in dit voorbeeld bekijken is welke invloed het weglaten, het negeren of het aanpassen van de uitbijters heeft op de correlatie. De eerste test (test = 0) is de analyse met de univariate uitbijters.

In de opeenvolgende test worden de waarden van de uitbijters telkens iets meer naar het centrum van de verdeling verschoven. De laatste test (test = 14) is uitgevoerd nadat alle uitbijters de waarde ‘missing’ hebben gekregen. Het is duidelijk dat de uitbijters een sterk effect hebben op de correlatie, zelfs als ze minder extreem worden gemaakt. In dit voorbeeld is het waarschijnlijk verstandig om de uitbijters de waarde ‘missing’ te geven en eventueel een imputatiemethode (zie hoofdstuk Ontbrekende waarden) toe te passen.

Dit is slechts een voorbeeld van een sensitiviteitsanalyse. De techniek kan ook in allerlei andere situaties worden toegepast.

19.5 Controleren van verdelingsvormen

Hoewel het controleren van verdelingsvormen eigenlijk onderdeel is van het controleren van modelassumpties wordt het toch vaak als onderdeel van de datascreening gezien. Wanneer je een analyse uitvoert uit de familie van lineaire modellen, zoals de t-toets, of een van de ANOVA’s, dan is de assumptie dat de residuen van het lineaire model gecentreerd zijn rond nul, dus dat de meetfout willekeurig is, en dat de meetfout volgens de centrale limietstelling normaal verdeeld is.

In dit hoofdstuk wordt niet ingegaan op hoe per design de residuen op hun verdelingsvorm getoetst kunnen worden. Dit zal in de relevante hoofdstukken toegelicht worden. In het geval van t-toetsen of factoriele ANOVA’s volstaat het bijvoorbeeld om de verdelingsvorm per groep te evalueren. Dit is echter geen goede optie meer zodra een model covariaten bevat, of als er geen groepen vergeleken worden zoals in regressieanalyse. In dit hoofdstuk worden de meer algemene richtlijnen bij veelgebruikte statistische methoden besproken.

Er zijn legio hardnekkige, bijna dogmatische misconcepties over deze assumptie van normaliteit. De twee meest relevante worden eerst besproken. Daarna volgt een bespreking van methoden om de normaalverdeling van residuen te evalueren of te toetsen.

1. De misconceptie dat een variabele normaal verdeeld moet zijn.

Er is geen goede reden waarom een variabele normaal verdeeld zou moeten zijn. Als een onderzoeker een behandeling tegen traumaherbelevingen onderzoekt, dan is het mogelijk dat de controlegroep gemiddeld veel herbelevingen heeft, en de experimentele groep gemiddeld weinig. De verdeling van de variabele ‘herbelevingen’ kan in een (voor de onderzoeker) gunstig geval dus best tweetoppig zijn (bimodaal). Dat vormt voor de statistische toets meestal geen bezwaar. De assumptie van normaliteit betreft namelijk niet de verdeling van de variabele, maar van de residuen.

Niet-normaal verdeelde variabelen kunnen soms ook realistisch zijn. De telling van gebeurtenissen, zogeheten count-data, zoals het aantal ambulances per uur dat bij een ziekenhuis aankomt in een tijdspanne van twaalf uur, of het aantal alcoholische dranken in een gegeven week zullen vrijwel nooit normaal verdeeld zijn. In de populatie zijn deze variabelen bijvoorbeeld poisson-verdeeld (waarde nul als harde ondergrens, met een modus nabij de nul, en een lange staart). Er zijn vele soorten verdelingsvormen, en dat variabelen zich soms naar deze verdelingsvormen gedragen kan volkomen logisch zijn en staat statistische analyse niet in de weg.

De assumptie van normaliteit betreft de residuen, dus zolang een model met één of meer variabelen normaal verdeelde residuen heeft, is het geen probleem als de gebruikte variabelen niet-normaal verdeeld zijn.

2. De misconceptie dat bij een voldoende grote N (N > 30) de steekproef als normaal verdeeld verondersteld mag worden

De centrale limietstelling wordt dikwijls aangehaald om te beweren dat een voldoende grote steekproef de variabelen of residuen normaal verdeeld maakt. Dit is echter geen juiste toepassing van de centrale limietstelling.

De centrale limietstelling (Engels: central limit theorem, CLT) gaat over de verdeling rond de modelschatting, zoals het populatiegemiddelde van een variabele.

De onjuiste veronderstelling dat een steekproef normaal verdeeld is bij \(N > 30\) heeft haar oorsprong in de CLT. De CLT stelt dat de steekproevenverdeling, dus de verdeling van de gemiddelden van een oneindig aantal steekproeven, normaal verdeeld zal zijn (ook als de steekproeven dat zelf niet zijn), mits iedere steekproef voldoende groot is. Voldoende groot wordt dan vaak gedefinieerd als \(N > 30\). Maar deze minimale steekproefgrootte uit de CLT zegt niets over de omvang van de steekproef die je hebt getrokken voor je onderzoek.

Dit betekent in de praktijk dat een onderzoeker weinig heeft aan de vuistregel van \(N > 30\). Door de assumptie van normaal verdeelde residuen, moet de verdelingsvorm toch gecontroleerd worden. Het is niet nodig om streng te zijn bij het evalueren van een verdelingsvorm, maar het is ook niet zinvol om geen enkele blik op de verdelingsvorm te werpen.

Hieronder worden drie methoden besproken voor het controleren van verdelingsvormen van de residuen. Maar voordat we dat doen, noemen we enkele belangrijke zaken om in gedachten te houden.

- Zie het controleren van verdelingsvormen en het identificeren van uitbijters eigenlijk als één stap. Het kan zijn dat uitbijters een verdelingsvorm zeer scheef maken. Het verwijderen of aanpassen van uitbijters kan vaak al een ogenschijnlijk probleem met de normaal verdeling van residuen oplossen.

- Het is geen absolute voorwaarde dat de steekproefresiduen normaal verdeeld zijn.

Wiskundige statistiek maakt zich zelden druk over echte observaties, en CLT is daar geen uitzondering op. Er wordt aangenomen dat de residuen in de populatie normaal verdeeld zijn. Zolang er geen apriori reden is om deze aanname te betwisten, dan is eigenlijk aan de aanname voldaan. Er hoeft dus niet getoetst te worden of aan de aanname van normaal verdeelde populatieresiduen voldaan wordt. Er hoeft eigenlijk alleen bepaald te worden of de steekproefresiduen voldoende normaal zijn, al is dit geen absolute voorwaarde.

Om deze reden is het belangrijk om niet te streng te zijn. Statistische criteria zijn arbitrair en als deze al gebruikt worden is het niet nodig om strenge alfa’s te gebruiken. Statistisch toetsen van de verdeling heeft dus niet altijd de voorkeur, en wanneer statistische toetsing wel gebruikt wordt, dan wordt dat het liefst gedaan met een lage alfa, zoals \(\alpha = .001\). Het zal inmiddels niet meer verbazen dat de meningen over de beste alfa verdeeld zijn. Het is in ieder geval niet zo dat een \(\alpha = .05\) een gangbaar criterium is. Het leidt te vaak tot de conclusie dat een assumptie van normaliteit geschonden is.

Ook is het niet altijd nodig om maatregelen te treffen wanneer de residuen niet voldoende normaal verdeeld zijn. Dikwijls wordt het advies gegeven om nonparametische toetsen te gebruiken, dus om het meetniveau van de variabelen te verlagen. Zoals eerder besproken hebben nonparametrische toetsen minder power dan hun parametrische equivalenten, dus het middel kan vaak erger zijn dan de kwaal; het kleine beetje powerverlies door net niet normaal verdeelde variabelen wordt ingeruild door substantieel powerverlies door het feitelijk verlagen van het meetniveau van de afhankelijke variabele. Soms wordt het advies gegeven om variabelen normaal verdeeld te maken, bijvoorbeeld door de wortel van elke waarde te trekken bij milde scheefheid, of het logaritme te nemen bij extreme scheefheid.

Deze databewerkingen zijn ooit bedacht voor situaties waarin bekend is dat de populatie normaal verdeeld is. Maar niet iedere variabele hoeft in de populatie normaal verdeeld te zijn, en dit is geen probleem, omdat de assumptie niet de variabele, maar de residuen betreft. Deze oplossingen zijn niet fout, maar ze horen eigenlijk niet als een generieke oplossing voorgesteld te worden. Het zijn oplossingen met veel haken en ogen, die de interpretatie van toetsuitkomsten zeer lastig kunnen maken. Wijk eigenlijk alleen af van het analyseplan als je bekend bent met de voors en tegens van de bewerking van de data.

19.5.1 Visuele evaluatie: P-P en Q-Q plots

Een volkomen legitieme methode voor het evalueren van de verdelingsvorm van residuen is het visueel inspecteren van de residuen. Histogrammen en boxplots kunnen vaak al voldoende duidelijk maken of bij benadering de residuen een normaalverdeling volgen. Deze visualisaties zijn echter niet ontwikkeld met dit doel in gedachten en het zijn dan ook methoden met een lage resolutie. Er zijn ook instrumenten die beter geschikt zijn, zoals de P-P- en Q-Q-plots.

P-P-plots zijn plots waarin een veronderstelde cumulatieve kansverdeling (standaard wordt in de meeste analysesoftware de normaalverdeling gekozen) uitgezet wordt tegen de cumulatieve steekproefverdeling. Als de steekproefverdeling bijvoorbeeld perfect normaal verdeeld is, dan zal deze één-op-één gelijklopen met de ideale kansverdeling. In een P-P-plot betekent dit dat de observaties perfect diagonaal oplopen. In een Q-Q-plot worden de kwantielen (Engels quantiles) van de theoretische kansverdeling uitgezet tegen de kwantielen van de steekproefverdeling. De P-P-plot en Q-Q-plot lijken op elkaar, maar ze zijn niet hetzelfde en worden ook net anders geïnterpreteerd. Er zijn specifieke situaties waarin de ene plot krachtiger is dan de ander.

Maar in de praktijk zijn de plots voldoende vergelijkbaar: als ze een lineair patroon vertonen dan volgen de observaties een normaalverdeling. Afwijkingen van de rechte lijn wijzen op scheefheid van de verdeling.

19.5.2 Evaluatie van globale verdelingsvormkenmerken: kurtosis en skewness

Het kan soms lastig zijn om vertrouwen te hebben in de eigen interpretatie van P-P- of Q-Q-plots, of om beknopt de evaluatie van deze plots in een verslag te beschrijven. Hoewel figuren meer zouden zeggen dan duizend woorden kost het vaak toch minder woorden om een paar getallen in een verslag op te nemen, dan een toelichting te geven op conclusies op basis van figuren. Een aardige middenweg tussen visuele inspectie en keihard toetsen is het statistisch evalueren van de globale normaalverdelingskenmerken. Je bekijkt dan of het gemiddelde gelijk is aan de modus (dus of de verdeling symmetrisch is) en of de kenmerkende klokvorm zich voordoet, en de verdeling dus niet platter of gepiekter is dan normaalverdelingen meestal zijn. Deze twee kenmerken, scheefheid (skewness) en gepiektheid (kurtosis), kunnen uitgedrukt worden in een toetsstatistiek.

Skewness. Skewness is een indicatie van de symmetrie (of eigenlijk de asymmetrie) van een verdeling. Als de skewness gelijk is aan nul (skewness = 0), dan is de data perfect symmetrisch. Dit betekent dat de modus, de piek, perfect in het midden ligt.

Als de skewness een positief getal is, dan is de verdeling rechtsscheef, en is dus de staart rechts van het gemiddelde langer dan links. Tegenintuïtief betekent dit dat het grootste cluster van waarnemingen dus links van het gemiddelde ligt. Als de skewness een negatief getal is dan is de verdeling linksscheef. Dan is dus de linkerstaart het langst, en ligt het grooste cluster van waarnemingen rechts van het gemiddelde.

Er zijn twee veelgebruikte, hoewel arbitraire, vuistregels om te bepalen of de skewness voldoende hoog is om te besluiten dat een verdeling scheef is. Meestal kiest men voor een van de volgende vuistregels.

- Een populaire vuistregel is dat als de scheefheid kleiner is dan \(-1\), of groter dan \(+1\) dit voldoende reden is om de verdeling scheef te noemen.

- Soms wordt nog gesteld dat wanneer de scheefheid tussen de -\(\frac{1}{2}\) en \(-1\), of tussen \(+1\) en +\(\frac{1}{2}\) ligt dit matige scheefheid genoemd mag worden. Deze vuistregel is tamelijk streng.

- Een andere populaire vuistregel is een nulhypothesetoets: door de skewness te delen door de standaardmeetfout van de skewness wordt de skewness omgezet in een z-score. Bij een alfa van \(\alpha = .001\) is de z-score van de skewness significant bij een \(z < -3.29\) of \(z > 3.29\).

Hoewel de drempelwaarden arbitrair zijn is het toch handig om deze vuistregels te gebruiken, en pas afwijkende drempelwaarden te gebruiken wanneer je die kunt onderbouwen.

Kurtosis. Vaak wordt kurtosis vertaald met gepiektheid, en wordt het als een uidrukking gezien van hoe stijl of plat de verdeling in het midden is. Het is maar de vraag in hoeverre kurtosis een indruk geeft van de piek, dus de massa van de verdeling in het centrum, of dat de kurtosis juist een indruk geeft van de massa in de staarten van de verdeling. Om deze discussie beknopt te vertalen: de vraag is of kurtosis aangeeft in hoeverre er teveel bescheiden afwijkingen van het gemiddelde zijn, of te weinig extreme afwijkingen van het gemiddelde. Wees dus voorzichtig met interpretaties van kurtosis die verder gaan dan de vaststelling of een verdeling meer of minder gepiekt is dan verwacht.

Zelden wordt in analysesoftware de ‘echte’ kurtosis weergegeven. Kurtosis in analysesoftware is dikwijls zo weergegeven dat een ‘nul’ de kurtosis van een perfecte normaalverdeling zou zijn. Maar de echte kurtosis van een normaal verdeling is niet nul, maar \(3\). Meestal wordt de ‘overvloedige’ (excess) kurtosis weergegeven, dus de werkelijke kurtosis min \(3\), zodat een perfect normaal verdeelde variabele een (overvloedige) kurtosis heeft van nul. Een kurtosis van \(+3\) in analysesoftware betekent dus eigenlijk ‘drie meer dan zou moeten’, dus dat de werkelijke kurtosis \(6\) is.

De kurtosis zoals weergegeven in de analysesoftware betreft dus de overvloedige kurtosis, maar slechts zelden wordt dit zo genoemd. Het weergeven van overvloedige kurtosis heeft als voordeel dat negatieve kurtosis (alles lager dan nul) en positieve kurtosis (alles hoger dan nul) eenvoudiger te herkennen zijn dan getallen onder en boven drie. De interpretatie van de kurtosis wordt hierdoor iets eenvoudiger.

Als in dit stuk geschreven wordt over de kurtosis, dan wordt dus de overvloedige kurtosis bedoeld, zoals eigenlijk in de regel wordt weergegeven in analysesoftware. Er zijn twee veelgebruikte, maar arbitraire vuistregels om te bepalen wanneer de kurtosis voldoende hoog (of laag) is om te besluiten dat een verdeling niet de juiste gepiektheid vertoont:

- Een populaire vuistregel is dat als de kurtosis kleiner is dan \(-3\) is, of groter dan \(+3\) dat dit voldoende reden is om de gepiektheid afwijkend te noemen.

- Als de kurtosis tussen de \(-3\) en \(+3\) ligt, dan wordt de gepiektheid als passend bij een normaalverdeling verondersteld.

- Kurtosis \(< -3\) heeft een platte, brede centrale piek, en korte, dunne staarten.

- Kurtosis \(> +3\) heeft een hoge, nauwe centrale piek, en lange, dikke staarten.

- Een andere populaire vuistregel is een nulhypothesetoets: door de kurtosis te delen door de standaarmeetfout van de kurtosis wordt de kurtosis omgezet in een z-score. Bij \(\alpha = .001\) is de z-score van de kurtosis significant bij \(z < -3.29\) of \(z > 3.29\).

Samengevat:

- Als skewness groter is dan \(-1\) én kleiner dan \(+1\) is, en de kurtosis groter is dan \(-3\) én kleiner dan \(+3\) is kan de verdeling als normaalverdeeld verondersteld worden.

- Alternatief: als de z-scores van skewness en kurtosis niet significant zijn bij \(\alpha = .001\) dan kan de verdeling als normaalverdeeld verondersteld worden.

Een lastige situatie ontstaat wanneer alleen skewness of alleen kurtosis binnen de grenswaarden valt. Er zijn geen duidelijke richtlijnen of vuistregels in deze situatie. Het gebeurt dus wel eens dat de kurtosis teveel afwijkt, maar de skewness normaal is, of vice versa. De vraag is dan dikwijls “is de data nu normaal verdeeld of niet?”. Over het algemeen wordt dit een beetje op gevoel opgelost, met in het achterhoofd dat de skewness een belangrijkere assumptie is dan de kurtosis. Dat de residuen symmetrisch gecentreerd zijn rond nul is een belangrijke assumptie. Hoe de staarten zich gedragen is niet onbelangrijk, maar minder belangrijk dan waar de piek in de verdeling zich bevindt.

Dus als de skewness in orde is, maar de kurtosis niet, dan wordt meestal aangenomen dat de residuen normaal verdeeld zijn. Maar uiteindelijk zul je in zo’n geval te rade moeten gaan bij de data zelf. Zijn er aanwijzingen in de data te vinden die scheefheid of gepiektheid kunnen helpen verklaren? Wat daar het antwoord ook op is: informeer de lezer altijd van je besluit en op basis waarvan dat genomen is.

19.5.3 Toetsing van de verdelingsvorm tegen de kansverdeling: Kolmogorov-Smirnov en Shapiro-Wilk’s.

Bij P-P- en Q-Q-plots werd de data geplot tegen een hypothetische verdeling, bijvoorbeeld de normaalverdeling. Vergelijkbaar met de Q-Q-plot is het met de Kolmogorov-Smirnov-toets (KS-toets) mogelijk om de verdeling van de data te toetsen tegen de nulhypothese dat deze data voortkomen uit een hypothetische verdeling, zoals de normaalverdeling.

Net als de Q-Q-plot deelt de KS-toets de data op in gelijke (cumulatieve) stukken en vergelijkt deze met hoe dezelfde stukken eruit zouden zien in een ideaal (normaal verdeeld) geval. De KS-toets geeft dus een indruk van hoe goed de data overeenkomen met de ideale verdeling, en wordt daarom een goodness-of-fitmaat genoemd. Doordat de data en nulhypothetische verdeling stapsgewijs worden vergeleken is de KS-toets een non-parametrische toets. De parametrische variant van deze toets is de Shapiro-Wilk’s toets (SW-toets). Als vuistregel geldt dat de KS-toets gekozen wordt bij een steekproef van \(N > 50\) en dat de SW-toets gekozen wordt bij \(N < 50\).

De SW-toets is iets minder krachtig wanneer data veel identieke waarden bevatten. Maar in de praktijk liggen de conclusies van de KS- en de SW-toets dicht bij elkaar, en over het algemeen zijn de methoden voldoende vergelijkbaar.

Beide methoden hebben echter een probleem waardoor ze niet dé voorkeursmethoden zijn. Ze zijn namelijk erg gevoelig voor de steekproefgrootte, en voor deze toetsen is \(N > 50\) al een grote steekproef. Hoe groter N des te eerder deze toetsen een significante uitkomst opleveren. Dit kan gecompenseerd worden met een strenge alfa, zoals \(\alpha = .001\), maar voor zowel de KS- als SW-toets zal een hoge N ook bij een strenge alfa (te) snel significant zijn.

De toetsen zijn bovendien alleen geschikt voor continue data. Hoewel data in psychologisch onderzoek continu kunnen lijken, valt in de praktijk tegen hoe continu veel data werkelijk zijn. Het gemiddelde van een set Likertschalen lijkt bijvoorbeeld continu, maar het aantal mogelijke gemiddelden is toch beperkt, en in de praktijk zullen bepaalde gemiddelden, inclusief de decimalen, zich herhalen over meerdere steekproeven. Als de data niet echt continu zijn, dan kan dat ervoor zorgen dat zelfs strenge KS- en SW-toetsing significant uitvallen.

De invloed van steekproefgrootte en van continue data maakt dat een significant resultaat van KS- en SW-toetsen vaak niet heel informatief is. Om deze reden wordt een KS- of SW-toets vaak in combinatie met een Q-Q-plot gebruikt. Wanneer plot en toets een andere conclusie lijken op te leveren dan wordt het meeste gewicht aan de Q-Q-plot gegeven. Wanneer daarentegen de KS- en SW-toetsen geen significant resultaat opleveren, is dat juist weer wel heel informatief.

Samengevat:

- Kies Shapiro-Wilk’s wanneer \(N < 50\).

- Kies Kolmogorov-Smirnov wanneer \(N > 50\).

- Als de SW- of KS-statistiek een \(p < .001\) heeft, dan geeft dit een significante afwijking van de nulhypothetische verdeling aan, de data lijken dus af te wijken van een normaalverdeling.

- Als de SW of KS niet significant zijn (\(p > .001\)) dan is dat informatief. Als de SW of KS wel significant zijn, zeker wanneer \(N\) groot is, of de data niet voldoende continu, dan is dit minder informatief, en kan het zinvol zijn een andere methode te gebruiken, zodat op verschillende manieren informatie verzameld wordt, en naast elkaar gelegd kan worden om een beter beeld te vormen, dus ter triangulatie.

19.6 Data-screening en open science

Tenslotte is het in het kader van de open-science principes heel belangrijk dat elke stap in het screening- en analyseproces reproceerbaar is. Dit betekent dat databewerkingen en analyses het beste kunnen worden uitgevoerd via een analyscript (code of syntax), en voorzien van toelichting. Het is ook mogelijk om via de menustructuur te werken, maar als de software dat toelaat is het dan belangrijk om een wijze van werken aan te leren die werken via de menustructuur reproduceerbaar maakt. Bijvoorbeeld door na het selecteren van opties, en bewerken van data de handelingen als syntax op te slaan, of deze in detail te beschrijven. Alle bewerkingen die op de data worden uitgevoerd, van het inladen van de ruwe data tot en met de analyses voor de uiteindelijke resultaten, moeten worden gedocumenteerd en toegankelijk gemaakt voor de buitenwereld. Hoewel dit in principe ook beschrijvend kan, is exacte reproductie dan vaak niet mogelijk. Door alles op een of andere manier in een te runnen analysescript te documenteren, zijn alle stappen volledig transparent. Iedereen kan dan de integriteit van de data en het gehele onderzoek verifiëren.